Los avances en inteligencia artificial generan tantas promesas como incertidumbre, sobre todo en el ámbito militar. ¿Qué grado de autonomía deben tener los sistemas que se utilizan en el área de defensa? Diversos países y organizaciones civiles promueven la necesidad de regular su uso de forma preventiva.

Agencia TSS – La semana pasada, en Ginebra, Suiza, se desarrolló la Convención sobre ciertas Armas Convencionales (CCA) de la Oficina de Asuntos de Desarme de las Naciones Unidas (UNODA), que busca prohibir o limitar el uso de armas que se considere que pueden causar daño innecesario o injustificado a combatientes y civiles, incluyendo los sistemas autónomos. A estos últimos se les ha dedicado especial atención durante los últimos años con el objetivo de determinar cuál debe ser el tipo y grado de control que debe haber sobre los sistemas que pueden actuar sin intervención humana.

La Argentina es uno de los 88 países que integran esa convención, desde el año 1995, y sostiene una posición “preventiva, apoyando la adopción de medidas para regular el desarrollo y uso de los sistemas de armas autónomos letales, aunque sin limitar los desarrollos tecnológicos con fines pacíficos”, afirmó el ministro Ricardo Larriera, director de Seguridad Internacional, Asuntos Nucleares y Espaciales del Ministerio de Relaciones Exteriores y Culto de la Nación, durante un encuentro organizado por la Asociación para Políticas Públicas (APP) y la red de Seguridad Humana en Latinoamética y el Caribe (SEHLAC).

La reunión se realizó en el marco de los debates que lleva adelante desde hace unos años la CCA, y dentro de la Campaña para detener los robots asesinos, que desde 2012 busca conseguir una normativa para prohibir las armas completamente autónomas y que “actualmente está integrada por una red de 89 organizaciones de la sociedad civil, con presencia en 49 países”, tal como detalló María Pía Devoto, directora de la APP y una de las fundadoras de SEHLAC.

“La división más significativa es entre países que todavía sostienen que esto no existe y que por eso es prematuro avanzar en medidas para regularlos, y los que sostienen que, más allá del desarrollo efectivo de sistemas autónomos, es necesario mantener un enfoque preventivo que asegure que todo posible desarrollo mantenga un margen significativo de control humano”, agregó Larriera y detalló que la postura argentina considera que las medidas preventivas deberían incluir que se mantenga el control humano sobre funciones críticas, que el uso de esos desarrollos tecnológicos no resulte violatorio del derecho humanitario internacional ni de los derechos humanos, y que no deberían acotar el derecho soberano al desarrollo de tecnologías similares con fines pacíficos.

“Estamos frente a una catástrofe: las armas autónomas ya son una realidad que puede cambiar la vida de muchos. Hoy ya no hay zonas militares, sino que el conflicto está en las calles. ¿Qué implica elegir las armas en base a algoritmos?”, preguntó Cristian Wittman, uno de los miembros fundadores de la Red SEHLAC.

Wittman dijo que, hasta el momento, la CCA no logró un instrumento efectivo de regulación bajo el concepto de desarme humanitario, entendido como aquel en el cual los países negocian teniendo en cuenta los efectos de las armas sobre comunidades, individuos y el ambiente. También cuestionó que en la última CCA se haya decidido reducir aún más el espacio de discusión vinculado con el uso de robots asesinos. La CCA toma sus decisiones por consenso unánime, lo que implica que una sola oposición es suficiente para que se caiga un acuerdo y, en este caso en particular, Rusia logró que el año próximo se le dediquen siete días a la discusión en vez de los 10 acordados previamente.

“Es posible lograr avances en el derechos internacional para el desarme humanitario, pero hoy la sociedad civil no tiene derecho de voto en la ONU y por eso es un deber de los gobiernos prohibir armas o regular su uso a partir de las consecuencias que puede tener en las víctimas. Hay que crear una regulación que prohíba estos robots asesinos de manera preventiva y también dejar espacio para el desarrollo tecnológico”, subrayó Whitmann, que es profesor de la Universidade Federal do Pampa, en Brasil.

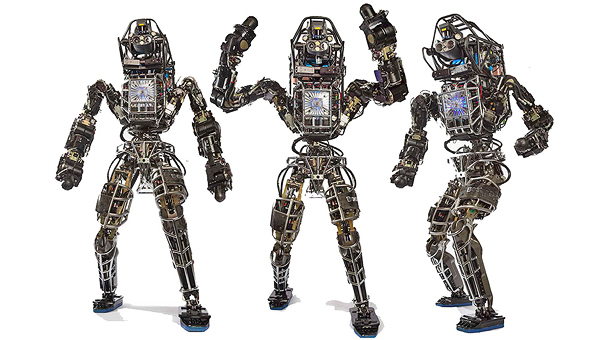

“No estamos hablando de un arma en particular, sino de la actividad de todas las armas posibles”, advirtió el científico Guillermo Simari, del Departamento de Ciencias e Ingeniería de la Computación de la Universidad Nacional del Sur (UNS), y recordó la carta que presentó la comunidad científica en la Conferencia Internacional sobre Inteligencia Artificial de 2015 (IJCAI 2015), que se realizó en Buenos Aires, en la cual especialistas del área ya se referían a los desafíos de la inteligencia artificial y la robótica. En ese documento, por ejemplo, se define a las armas autónomas como aquellas que pueden detectar un blanco sin intervención humana. “Eso es importante porque ese tipo de desarrollos ya se pueden hacer. De hecho, ya debe haber armas autónomas funcionando aunque nadie las publique”, sostuvo Simari, y recordó que una reciente demostración del presidente de Rusia, Vladimir Putín, “que para el ojo entrenado, se nota que ya usan aparatos inteligentes, lo que no es trivial: un misil que en vuelo puede cambiar de trayectoria, por ejemplo, supongamos que hace todo bien, lo que ya sería un problema. Pero, ¿y si se confunde?”, cuestionó el especialista.

(Des) inteligencia artificial

“Una de las características principales de los sistemas de inteligencia artificial es la idea de autonomía, por un lado, y de autodirección, de estar libre de todo control externo”, agregó su colega Vanina Martínez, que es doctora en Ciencias de la Computación, y subrayó que, a la hora de analizar estos sistemas es importante pensar qué tipo de inteligencia artificial se desea construir. “¿Vamos a crear inteligencia vacía, sin ningún tipo de código de valores? Estos sistemas deberían contemplar cuestiones de ética y valores desde el diseño mismo”, sostuvo la especialista y consideró que el potencial de la inteligencia artificial es tan grande que sería “un desperdicio para la humanidad” ocuparse solo de la inteligencia considerada racional. “Podríamos inculcarles cuestiones morales, éticas y valores, pero es muy difícil: ¿cómo hacemos para formalizar todo el conocimiento implícito que tenemos y no nos damos cuenta?”, se preguntó.

Al respecto, la especialista, que recientemente fue distinguida por la revista IEEE Intelligent Systems por la relevancia mundial de sus investigaciones en el campo de la inteligencia artificial, detalló tres limitaciones principales en los sistemas actuales: el sesgo, la explicabilidad y la transparencia.

Los sistemas actuales funcionan encontrando patrones en una gran cantidad de datos pero se entrenan en un conjunto de datos –como fotos de gatos y perros, por ejemplo– y el algoritmo abstrae patrones que le sirven para identificarlos. Sin embargo, esas mismas bases de datos pueden estar sesgadas por los humanos, por eso es importante identificar los datos que se ingresan, “porque si el conjunto de datos no representa a la población a la cual se va a aplicar ese algoritmo, no funciona. Si metemos basura, sale basura”, dijo la especialista y se preguntó: “¿Queremos inteligencia artificial para que haga lo mismo que nosotros o para mejorarnos como humanos?”.

La explicabilidad remite a la importancia de que los sistemas de inteligencia artificial no sean cajas negras como lo son ahora, sino que puedan ser interrogados. “En el caso de un sistema que ayuda a un médico con los síntomas de un enfermo es necesario que la persona pueda preguntarle por qué tomaría tal o cual decisión, y eso puede extrapolarse a las armas”, ejemplificó Martínez, a lo que su colega Simari agregó, como otras de las preocupaciones que generan estos sistemas, al autoaprendizaje y su posibilidad de automejorarse, razón por la cual en Europa, por ejemplo, ya existe una ley que prohíbe el uso de sistemas que no puedan explicar sus comportamientos en cuestiones públicas. “La automejora de los sistemas es un problema, porque uno no sabe cómo se mejoran. Si el sistema, además, es autónomo, puede decidir mejorarse en aspectos que no sean los que uno quiere”, advirtió.

La limitación de la transparencia de los sistemas de inteligencia artificial, en cambio, se vincula con que, a diferencia de otros sistemas en los cuales el solo hecho de ver el algoritmo permite entender cómo funcionan, en el caso de la inteligencia artificial “hay un algoritmo, pero el modelo que ellos generan está en otro lado. Se debería garantizar que estos sistemas sean trazables y auditables”, dijo Martínez.

Al respecto, Simari sumó el ejemplo de la Justicia de Estados Unidos, que está usando inteligencia artificial para evaluar pedidos de libertad condicional. “Si estos sistemas ayudan a almacenar y procesar datos, no hay problema, pero sí cuando los sistemas deciden solos”, dijo y agregó: “Necesitamos filósofos que investiguen esto para que después los científicos nos pongamos a trabajar. Debemos preguntarnos: ¿Queremos crear algo que va a ser mejor que nosotros? ¿Qué queremos desarrollar y de qué forma queremos usarlo? ¿Quién estará a cargo de esto en la sociedad?”.

![]()

29 nov 2018

Temas: Computación, Defensa, Ética, Inteligencia Artificial, Robots, Software