Los países de América Latina pueden tener un rol de liderazgo contra el uso de armas autónomas. Así lo plantearon investigadores, especialistas y activistas que participaron del segundo encuentro global de la Campaña de Prohibición de Robots Asesinos. ¿Cuáles son los desafíos que plantea la incorporación de avances en robótica e inteligencia artificial en el campo militar?

Agencia TSS – Las primeras investigaciones en el campo de lo que que se denominaría como inteligencia artificial comenzaron en la década de 1950. Desde entonces, prometen hacer realidad ese anhelo del imaginario social que ya se hacía evidente en el taller de Gepetto y el laboratorio del doctor Frankenstein. Más de medio siglo después, todavía no existe una tecnología capaz de procesar la información tal como lo hacen las personas, aunque muchos avances tecnológicos se le parecen y algunas máquinas, incluso, hasta son capaces de tomar decisiones. Esto, que alguna vez fue una especulación de la ciencia ficción, hoy es una realidad en dispositivos de uso común y en asistentes cotidianos de los usuarios de aplicaciones y sistemas informáticos como los traductores, el GPS y los buscadores que distinguen el spam en los correos electrónicos.

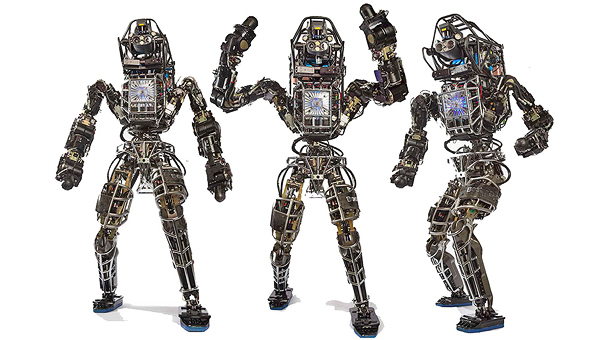

Las tecnologías de inteligencia artificial también tienen aplicaciones bélicas, no solo para asistir a los soldados en la guerra sino para tomar decisiones por ellos. Se los llama robots asesinos y no tienen nada tienen que ver con imágenes como las de Terminator, sino que se trata de complejos Sistemas de Armas Autónomas (SAA), que una vez activados pueden seleccionar y atacar objetivos sin intervención humana significativa. Para programarlos se utilizan metodologías como la de machine learning (aprendizaje de máquina), mediante las cuales es posible agregarles capacidades de aprendizaje, auto mejoramiento y auto adaptación.

“Son armas diseñadas para atacar a los humanos sin que participen los humanos. Pueden ser drones, tanques, submarinos, buques y otro tipo de instrumentos”, detalló Laura Nolan, una experta en ingeniería de software que hace dos años dejó su puesto de ingeniera senior en Google en protesta por el Proyecto Maven, una iniciativa militar de Estados Unidos que busca utilizar aprendizaje automático para clasificar imágenes de video filmadas por drones de vigilancia. La exposición de Nolan fue parte del segundo encuentro global de la Campaña de Prohibición de Robots Asesinos (Stop Killer Robots), que este año se realizó en el Centro Cultural de la Ciencia (C3), en el Polo Tecnológico de Palermo, del 26 al 28 de febrero pasados.

“Existe la idea de que la tecnología es neutral y que las máquinas cometen menos errores que los humanos, pero estos sistemas son igualmente vulnerables ya que son programados por personas que pueden equivocarse y, aunque no lo hagan, les transmiten sus sesgos, prejuicios y formas de ver el mundo”, agregó la investigadora Vanina Martínez, del Instituto UBA-CONICET de Ciencias de la Computación (ICC), que en 2018 fue distinguida por la revista IEEE Intelligent Systems por la relevancia mundial de sus investigaciones en el campo de la inteligencia artificial. Según Martínez, “la inteligencia artificial no deja de ser un software y sabemos que no hay ningún sistema seguro, todos son hackeables”.

Al respecto, el investigador del CONICET en la Universidad Nacional del Sur (UNS) Guillermo Simari explicó que, en algunos casos conocidos como sistemas de caja negra, se desconoce cómo los sistemas procesan la información para tomar decisiones, mientras en que otros, denominados “de caja blanca”, se tiene cierto conocimiento sobre cómo procesan la información pero consiste en encontrar datos existentes, por lo que se encuentran correlaciones pero no causas. “Las tecnologías de machine learning, que es uno de los modelos de inteligencia artificial, son entrenadas en un contexto bastante acotado y no pueden generalizar. El sistema de Google que juega al ajedrez no puede procesar datos”, ejemplificó Simari, que también fue distinguido por la revista IEEE Intelligent Systems por la relevancia mundial de sus investigaciones en el campo de la inteligencia artificial, y afirma que, si se quisiera usar alguno de estos sistemas en otro contexto diferente, habría que volver a entrenarlos. Este podría ser el caso de las herramientas actuales de reconocimiento facial, que funcionan muy bien en la cantidad de rostros que pueden reconocer, pero que también presentan un alto número de falsos positivos. Otra de las limitaciones de estos sistemas es que tampoco pueden entender reglas abstractas: “Usamos modelos básicos que, por ejemplo, no son suficientes para que entiendan los principios fundamentales del derecho internacional humanitario”, explicó Nolan.

“En general, cualquiera de estos modelos puede reproducir y perpetuar sesgos de datos y conocimiento experto. Por ahora, tienen una manipulación básica del lenguaje natural, pueden traducir pero sin comprender, no proveen explicaciones o interpretaciones de sus resultados ni están preparados para que un usuario cuestione una decisión”, dijo Martínez. “Todos usamos traductores automáticos y hemos encontrado errores”, agregó Tica Font, que es investigadora en el Centro de Estudios por la Paz (Centre Delas d’Estudis per la Pau), y enfatizó: “El problema cuando se trata de un arma es que siempre vamos a tener errores y el resultado puede ser la muerte”.

Aún así, este tipo de armas autónomas tiene defensores. Según datos de Pew Research, de mayo de 2015, el 58% de los estadounidenses aprobaba el uso de aviones no tripulados en ataques contra presuntos terroristas en países extranjeros. Por el contrario, científicos, tecnólogos y activistas de todo el mundo consideran que son un riesgo para la sociedad civil y presentan conflictos desde lo ético, lo moral, lo legal y hasta lo técnico. Por eso, desde hace años, piden la prohibición de su uso en todo el mundo, tal como se hizo con las armas láser cegadoras en 1998, debido al daño excesivo que pueden causar.

“La Argentina, Chile, Uruguay y Brasil pueden y deben tomar un papel de liderazgo en la lucha contra los robots asesinos. Junto con México, Costa Rica y Panamá podrían establecer una zona libre de armas letales, como paso previo hasta llegar a un tratado global”, dijo Jody Williams, Premio Nobel de la Paz en 1997 por su trabajo para erradicar las minas terrestres antipersonales a través del Tratado de Prohibición de Minas de 1997. En diálogo con TSS recordó que, durante la campaña antiminas, Bélgica fue el primer país en prohibirlas a nivel nacional, y luego se sumaron otros a la prohibición. “El cambio se da así, son etapas que ayudan a avanzar hacia un tratado internacional porque los países muestran que en verdad aprueban la prohibición”, subrayó.

La campaña Stop Killer Robots comenzó en abril de 2013 en Londres y, dos años más tarde, más de 700 científicos de todo el mundo –entre ellos el físico británico Stephen Hawking y el fundador de SpaceX, Elon Musk– publicaron una carta en la que advertían sobre los riesgos de estas tecnología y pedían que los avances en materia de inteligencia artificial sirvieran para beneficiar a la humanidad. Recientemente, un grupo de especialistas argentinos difundió una nueva versión de esa carta en español y en portugués, que ya contabiliza medio centenar de adhesiones de colegas de toda la región que trabajan en temas vinculados, no solo desde la inteligencia artificial y la robótica, sino también desde otras disciplinas como Derecho y Filosofía.

“Nuestra intención es reafirmar el compromiso de los científicos en la región y promover a América Latina como líder de este cambio que queremos generar en la sociedad”, afirmó Martínez y explicó que hoy existen distintas posiciones al respecto sobre una prohibición que para ella es necesaria. Una de las posturas propone establecer un tratado global preventivo e integral, legalmente vinculante, que prohíba el desarrollo de estos sistemas, mientras que la otra propone una moratoria en el desarrollo. “Independientemente de la prohibición o la moratoria, lo que me preocupa como científica es que esto se define en términos muy abstractos. Por ejemplo, ¿cuándo hablamos de que un algoritmo es equitativo y cómo definimos qué significa eso en términos técnicos?”, se preguntó.

“La violencia se perpetúa en el círculo de masculinidad asociada a la posesión de armas y al poder”, llamó la atención Jaqueline Sylvie Ndongmo Fouezet, coordinadora de la Campaña Stop Killer Robots en África, y recordó que las cuestiones de género no se refieren a diferencias biológicas, sino a roles sociales que son asignados a una persona según el grupo al que pertenece, algo que es central en este tema, puesto que afecta en el modo en que la violencia, las armas y la guerra son pensadas.

“Las corporaciones también juegan un rol relevante en este proceso que es necesario deconstruir, puesto que la armamentización de la tecnología y la militarización de las sociedades sirven para perpetrar la violencia de género, así como el racismo cultural y religioso”, dijo Ndongmo Fouezet, que también es representante de la región de África de la Liga Internacional de Mujeres por la Paz y la Libertad (WILPF) y presidenta de la sección de Camerún.

Detrás de las balas, aparecen las víctimas. “¿Se imaginan que a las Madres de Plaza de Mayo les dijeran que una máquina ha matado a sus hijos? ¿A quién le vamos a reclamar? ¿En qué espacio público tendremos un símbolo de protesta contra una máquina? ¿Cuál sería el castigo para un robot? ¿Desconectarlo?”, se preguntó Font, que es física nuclear. Y sostuvo: “Se están creando sistemas impunes para matar: las víctimas no van a poder tener justicia, ni verdad, ni reparación”.

![]()

05 mar 2020

Temas: Armas, Armas autónomas, Inteligencia Artificial, Robótica, Robots asesinos, Software